整理|周鑫雨 王奕昕欧洲杯体育

文|周鑫雨

裁剪|邓咏仪

2024年1月,Sora炸场,多模态赛说念则迎来了确实的春天。

OpenAI发布的视频模子Sora,不仅将视频生成长度的天花板从10秒举高到了60秒,还让AI行业从大真金不怕火大谈话模子,进入到新阶段:通过原生的多模态模子(而非多个单模态模子拼接),加快探索通往AGI(通用东说念主工智能)的可能性。

在2024年的智源大会上,智源研究院不仅发布了不错生成和知道视频的原生多模态模子Emu3,还请来了两位Sora摇风眼中的东说念主物:

Aditya Ramesh,OpenAI的多模态扛把子,图像生成模子DALL·E之父,同期亦然Sora的团队负责东说念主之一。

在2024年4月的播客访谈中,他建议,像Sora这么的模子是好意思满AGI的重要技艺,因为省略模拟复杂的环境和宇宙。

谢赛宁,纽约大学计较机科学助理教训。他和OpenAI Sora的另一位中枢成员William Peebles(昵称Bill),首创性地将Transformer与扩散模子勾通,其研究后果DiT,也成为了Sora的中枢架构。

在以“生成建模如何发展”的接头中,Aditya Ramesh梳理了从DALLE·1到Sora的视觉生成技巧探索旅途。

他提到,视觉生成照旧阅历了手动打标签、知道谈话和图像的映射、从视觉中建构当然谈话、从当然谈话中构建视觉4个阶段。而下一阶段,则是让当然谈话去建构一切模态。

△Sora负责东说念主Aditya Ramesh与谢赛宁对谈现场 图源:智源研究院

在和谢赛宁的调换中,两东说念主研究了DiT架构对视觉建模的价值、通往AGI需要的东说念主才、视频生成模子的应用,以及视频生成模子的测验数据起头。其中的不雅点有:

谈话是一切模子的支架,表面上不错测验任何模态的模子。跟着参数领域的增大,模子对谈话的依赖进程会裁减,何况驱动学会我方科罚问题。

纳入在校生东说念主才,是OpenAI的招聘战术。OpenAI更关注有后劲但还没获取注重学术收获的东说念主才,好多告成的研究者并莫得经过传统研究的注重培训。同期,给东说念主才充足的GPU,是很进犯的!!

淌若省略补助可控性,何况机动使用现存场景中的扮装、财富和其他元素,视频生成模子很有可能会成为用户界面的游戏改变者。

现存来自互联网的数据可能照旧让咱们走得很远了。通过通过连续扩大模子领域,一朝模子强盛到成为孤独的宇宙模拟器,你就不错驱动在视频生成模子里面进行讲和、模拟等操作

以下是Aditya Ramesh和谢赛宁的对话实录,经《智能泄漏》整理裁剪:

谢赛宁:我在你的X账号中看到了一句话:“谈话模子被高估了。”当作视觉研究诞生的东说念主,我真的很心爱这个说法。但你认为视觉生成是通往AGI的重要说念路吗?你如何看待建模东说念主类谈话与建模包含丰富感官数据的实际宇宙之间的联系?

Aditya Ramesh:我对此很校服。在职何给定的视频中,你都不错获取好多信息,何况视频中的好多信息用谈话很难示意。举例,我谈到了雷门的渐进矩阵,从视觉中学习到的智能类型,很难只是通过学习谈话来建模。

是以我认为,谈话将是更高阶的智能系统的进犯构成部分,不错推理事物。但在某一时刻,我认为漫谈会被纳入视觉,这是一种更通用的界面。

谢赛宁:你提到,谈话不错成为好意思满智能的框架。为了弥补视觉阐扬的不及,谈话确乎提供了额外多的先验常识。那么漫谈会成为一种捷径吗?你对此有什么办法吗?

Aditya Ramesh:我所守望的是,当你用强形貌性的文本测验文生图模子时,它莫得太多需要学习的东西。然而咱们在DALL·E 3中看到的是,当在确实的形貌性文本以及一些漫笔本上测验模子时,漫笔本测验的模子的性能会因为在更具形貌性的文本上测验而补助。

因此,也许咱们不错使用谈话来测验生成模子,并匡助它们更灵验地测验。然而跟着参数领域的扩大,模子对谈话当作条目信息的依赖进程将会裁减,何况不错驱动自行科罚问题。

谢赛宁:我想聊聊Sora背后的天才。Bill(Sora其中一位负责东说念主)在博士的临了一年和我一说念研究DiT,而Tim(Sora其中一位负责东说念主)在伯克利攻读博士学位时间一直勤奋于于长视频生成。这两位刚刚获取博士学位,就能对这个领域产生如斯大的影响,这真实太了不得了。

OpenAI的团队文化是奈何救援年青研究院施展他们的脸色、夙昔的教学,为团队作念孝顺?

Aditya Ramesh:OpenAI的招聘战术与其他组织额外不同。虽然,Tim和Bill在加入OpenAI之前领有博士学位和相当强的后果发表,但咱们更关注那些有高后劲,但可能还没契机获取注重学术收获的东说念主,举例,James Becker,DALL·E 3的负责东说念主之一,他匡助将音频功能镶嵌GPT-4o。他是一个很好的例子。

其次,咱们专注于领有一个长久的研究目标,而不会受到领域进展的影响。也便是说,咱们设定了一个实足远处的目标,咱们不错整个专注于此,而不是对每天变化的事件作念出响应。

临了,我认为让每个东说念主领有充足的GPU很进犯。

△Sora负责东说念主Aditya Ramesh与谢赛宁对谈现场 图源:智源研究院

谢赛宁:我还庄重到,和OpenAI一样,有好多额外告成的研究东说念主员并莫得确实阅历所谓的传统研究、注重的研究培训。就像刻下高级训导的作用一样,你认为博士学位也被高估了吗?你有给想在AI从事做事的下一代研究东说念主员的建议吗?

Aditya Ramesh:我认为,咱们刻下通过 Transformer 和谐了可膨胀的计较范式,也知说念如何表征数据,技巧正在趋同。

我认为,它会改变你在学术界追求的神态的焦点,比如可诠释注解性是咱们追求的一个场地。我认为刻下攻读博士学位并守望获取起初进的后果是很用功的,因为所需的资源比以前高得多。

谢赛宁:我知说念你们有一个研究侦查谋划,不错为学术界提供一些学分,用于LLM和多模子学习的研究。我认为在工业界和学术界之间诞生这种类型的协调伙伴联系的契机好多。

好多东说念主对Sora也感到额外同意,咱们也额外心爱你在酬酢媒体上共享的视频。但问题是咱们仍然无法侦查它。你可能照旧看到了最近发布的一些同类居品,比如短视频公司快手的Kling,还有Luma AI的Dream Machine。是以我想听听你的办法,你如何看待视频生成领域的竞争?以及有莫得Sora的最新音问?

Aditya Ramesh:我认为像Sora一样强盛的视频生成系统,咱们最矜恤的主要是安全以及它对社会的影响。咱们要严防确保当咱们发布像Sora这么的模子时,东说念主们不会把它用于纰缪信息的生成和传播,同期模子的步履方式也要稳健东说念主们的守望。

总的来说,有竞争是很好的。很闲散看到其他实验室和公司也发布视频生成模子。我认为大都的东说念主用不同的步调责任,会激勉创造力。

记忆起DALL·E 2的研究时期,那时Google Brain和OpenAI实验室轮替发表论文,股东扩散模子的起初进技巧的发展。举例,Profful和Alex撰写了论文《扩散模子在图像合成上特殊GANs》,并给出了分类器教导,接着Jonathan Ho和其他东说念主又发布了无分类器的教导。

谢赛宁:最近我参加了纽约的AI电影节。我问通盘的艺术家和电影导演一个问题:你确实需要的视频生成模子的一个特征是什么?令东说念主骇怪的是,他们的谜底都是一样的:更好的可控性。

我想知说念这是否是Sora鄙人一个版块中也会关注的事情?通过和不同的艺术家协调,你学到了什么吗?漫谈会成为创意宇宙更好可控性的终极媒体界面吗?

Aditya Ramesh:我认为更好的可控性和减少立时性是咱们从协调者那边得到的头号功能恳求。我认为省略作念到这少量,并重用以前场景中的扮装、财富和其他元素将是一个要紧变革。只是这少量,就能使视频生成模子在分娩环境中变得有用。我以为这有点意思意思,因为在DALL·E 1的早期,咱们就看到了陡立体裁习才智的出现,刻下这些才智正在参预分娩。

谢赛宁:我想问一些对于数据的问题。因为我知说念好多Sora使用的数据来自互联网视频。为了通往AGI,像刻下这么的互联网视频足以救援这个目标吗?照旧说咱们需要发现新的数据源,以至需要不同的感官引子来匡助好意思满这个目标?

Aditya Ramesh:我认为现存的数据可能照旧让咱们走得很远了。我认为,咱们不错通过扩大模子领域,来连续取得很猛进展。

一朝模子强盛到成为孤独的宇宙模拟器,就会发生好多意思意思的事情,你就不错驱动在视频生成模子里面进行讲和、模拟等操作。这么咱们就不错驱动会通实际宇宙环境的通盘种种化和意思意思的敛迹,并驱动学习意思意思的东西。

以下是Aditya Ramesh对于视频生成建模技巧旅途探索的共享,内容经《智能泄漏》整理裁剪:

Aditya Ramesh:嗨,很行运能在这里演讲,我是OpenAI视频生成的负责东说念主。今天我想谈谈谈对于夙昔几年生成建模如何发展的不雅察,以及我认为事情会走向何方。

我想先谈谈一个相当陈旧的贬抑,至少在深度学习方面是这么。在2021年1月,咱们发布了一篇对于DALL·E 1的博客著述,这是一个大领域的自记忆Transformer模子,至少在那时是这么,它是在文本和量化图像上蚁合测验的。

咱们决定这么作念的原因,是因为咱们看到了Transformer建模谈话的初步人命迹象,咱们想知说念一样的技巧是否不错膨胀到其他模式的建模。它最终责任得很好,该模子省略输入笔墨,并将其退换为量化的图像补丁。

图源:智源大会直播截图

它的责任方式是给定一个谈话Prompt,您的建模就像通用的谈话模子一样对其进行建模。咱们还为图像测验了一个 VQ-VAE 编码器,图像块的镶嵌会被谈话的镶嵌增强。

很酷的是,咱们看到了DALL·E的领域加多,就像咱们今天看到的谈话模子领域加多一样。如果你测验一个小领域的自记忆图像模子,你不错看到生成的图片中出现了光照和反射、重迭的物体,以及小领域给事物上色的才智。

接着,在咱们测验的略微大领域的模子中,就不错画图具有多个属性的对象、改变艺术立场等等。一朝领域再次过大,就不错看到文本渲染、组合泛化以及图像陡立体裁习的迹象。

图源:智源大会直播截图

是以咱们试着作念一些事情,比如对DALL·E进行雷文渐进式推理矩阵测试(Raven’s Progressive Matrices Test),这是一种视觉技艺测试,模子看到网格中的前八个元素,必须填写临了一个边缘。咱们还尝试了图像到图像的退换,给模子一张图像的上半部分,要求它画图下半部分。当模子参数领域达到十亿后,测试的贬抑驱动转好。

咱们想知说念,如果进一步扩大领域会发生什么?

在DALL·E之后,我在想:这是学习智能的好步调吗?因为你正在测验一个模子来压缩视觉宇宙中的通盘像素。这似乎是一项相当用功的任务,有好多信息需要建模。

那时有一些研究标明,这并不是正确的遴荐。Mark Chen之前测验了iGPT,这是第一个对于图像的自记忆Transformer大模子。意思意思的是,只是通过学习灵验地压缩图像,模子就不错学习视觉宇宙的底层结构,并最终获取精粹的图像阐扬。举例,当加多iGPT模子的参数领域时,它在ImageNet数据库探针上获取精粹的贬抑。

关联词,这比与DALL·E 1同期发布的CLIP着力低得多。CLIP背后的办法是学习文本-图像数据集之间的共有信息。你遐想一个带有文本和图像的维恩图,CLIP使用对比蚀本来尝试学习数据集之间的共有信息。这最终比iGPT更灵验地从图像中获取信息。

是以那时我得出论断:DALL·E 1是一个意思意思的神态,但这并不是从视觉宇宙中索取智能,并通往AGI的重要旅途。

刻下我将略微谈谈CLIP如何索取文本-图像数据集之间的共有信息。CLIP包含一个图像编码器和一个文本编码器:文本编码器接收文本Prompt,图像编码器接收图像。

在测验时间,CLIP模子会得到一个“图像-形貌文本”数据对列表当作测验数据。文本编码器编码通盘形貌文本,图像编码器编码通盘图像,临了对比蚀本优化,两个编码器从而对皆每个数据对的表征。

图源:智源大会直播截图

CLIP的发布带来了强大的范式挪动,因为咱们无谓手动标注,而是不错诳骗互联网上的目田款式文本,来学习一个适用于通盘领域的优秀分类器。

比如你想对动物进行分类,你不错为你想分类的动物类别构建一个Prompt列表,然后将想要分类的图像的镶嵌与列表中的通盘文本形貌作念点乘,您想对通盘标题进行分类,然后取该点积的Softmax分数的最大值对应的类别当作分类贬抑。

从那时起,“图像示意学习”领域驱动发展。在早期,分类模子只是从图像中索取一些信息,即图像所属类别的标签。多年后,CLIP出现了,刻下咱们不错径直诳骗互联网上的文蓝本学习通用分类模子。紧接着,图像捕捉器也成了可膨胀的视觉学习器。

因此,与其使用对比蚀本来建模文本和图像数据集的共有信息,咱们不错测验一个具有图像编码器的感知模子,诳骗视觉信息重建当然谈话,就像谈话模子一样。

图源:智源大会直播截图

看起来,跟着时候的推移,视觉建模变得越来越简单。咱们的问题是:跟着算力预算的加多,图像示意学习最终形态会是若何?

iGPT的启示是,大领域参数的生成模子省略自动学习数据的底层结构,并最终产生精粹的图像示意。

那么“文本-图像”模子是否也有访佛的贬抑?事实上确乎如斯。

不久前发表的一篇名为“Your Diffusion Model is Secretly a Zero-Shot Classifier”的论文的基本想想是,即使对给定文本形貌的图像进行建模,该模子也不错退换为分类模子。它的责任方式与给定图像和形貌文本的CLIP并莫得太大的不同,你不错使用扩散模子来计较图像与文本匹配进程的分数,只是预计图文数据相似度的函数更为复杂。

这篇论文标明,骨子上稳固的扩散模子,省略获取精粹的ImageNet探针测试贬抑。

这是一个令东说念主骇怪的贬抑。这么一来,咱们就不错从以图像为条目预计标签的测验范式,转向以文本为条目预计图像的测验范式。然而刻下还不明晰这是否灵验,或者咱们需要额外破耗些许计较量来完成任务。

测验DALL·E 3时,咱们发现,当测验文本更具形貌性时,测验“文生图”生成模子的着力也会变得更高。即便文本很短,惟有具有很强的形貌性,测验效果也很好。这标明,咱们不错使用强形貌性文本当作测验框架来测验更好的无条目模子。

图源:智源大会直播截图

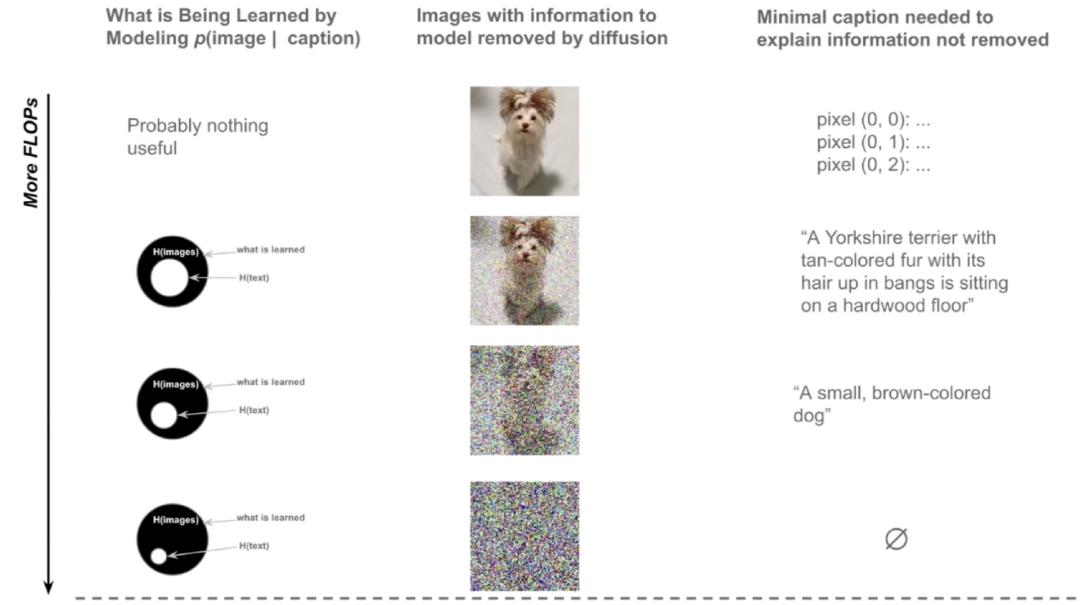

如图所示,第一列的图像添加了不同进程的噪声,这些噪声示意建模图像的不细则信息。右边一列代表形貌图片的最简单文本,比如只是形貌图像中每个像素的脸色。

假定基于这些图像测验一个文生图模子,由于咱们不错用文本形貌每个像素,是以图像莫得任何的不细则性,不需要深度学习模子。假定在图像中加入少量噪声,比如去掉一些名义细节和纹理,刻下就有了一些不细则性,模子需要学习的东西未几,剩余的不细则性不错用一个强形貌性的文蓝本形貌。

假定你给图像添加大都噪声,就会存在好多不细则性。诠释注解图像的剩余部分只需要直率的形貌。当图像被添加成为纯噪声,就莫得文本不错形貌剩下的图像,此时任何图像都有可能。

如果一个模子只是在学习将像素值退换为图像,它可能并莫得确实学到任何有用的东西。如果你有更多的算力,那么你不错测验一个将确实形貌性的图像、确实形貌性的文本翻译成图像的模子。直观上,它可能莫得学到好多东西,因为你给它的标题是如斯的形貌性,以至于图像中莫得太多的不细则性不错让它学习。如果算力更多,你不错期待这个模子不错使用更短的笔墨,建模莫得任何条目下的图像的熵。

咱们认为,诳骗高形貌性文本测验,有助于在小领域模子上补充感知研究的先验。这意味着咱们不错从基于形貌性文本的测验,转化到漫笔本的测验,即便在小参数领域下,当你给它形貌性字幕时,它仍然不错是一个好的图像生成模子。当参数目较大时,它不错学习无法用谈话应酬形貌的只是,并在某种进程上填补剩余的空缺部分。

这标明,咱们不错从测验给定图像的文本模子,切换到测验给定文本的图像模子,而且不会对计较着力形成太大的影响。如果你在形貌性文本上扩大模子参数,无条目建模任务的性能也会补助。

图源:智源大会直播截图

在通盘这个词探索流程中,当先咱们并莫得不绝使用文本,只是预计一些信息来测验图像分类器。然后咱们驱动在测验CLIP等图生文模子的流程中,更多地使用文本。最终咱们不错通过使用高形貌性的文蓝本测验优秀的生成模子,比如DALL·E 3和Sora。最终,跟着咱们进一步膨胀,也许漫谈会成为后续不错丢弃的框架,视觉宇宙可能是一个比文本更通用的界面。

接下来,我将谈谈当咱们顺从这个范式时会发生什么。咱们当先从图像建模文本驱动,刻下咱们从文本建模图像。跟着咱们不断加多计较,谈话的作用似乎正在被纳入视觉。

咱们在DALL·E 1上也看到了一些意思意思的东西,你不错作念一些意思意思的立场转化。你拿一张图片,然后使用CLIP镶嵌的算法来改变图片的一些细节。

通过实足参数领域的视觉陡立体裁习,咱们在DALL·E 1上看到了一些“人命”迹象。比如,给模子一个图像的上半部分,并要求它画图图像的下半部分,并对图像的上半部分进行一些调动。这个模子从来莫得被明确测验来完成这么的任务,但在实足的参数领域下,它最终照旧学会了这少量。咱们嗅觉这可能是通往各式视觉处理任务的通用界面的路线。

图源:智源大会直播截图

刻下,咱们驱动测验出可靠的视频生成模子。在改日,也许咱们不错向模子展示咱们所领有的图片,并要求它生成视频以达到咱们想要的效果。

这便是我的简单不雅察。学习压缩一切可能是正确的步调,而谈话只是使其实用的必要框架。但这还不够。咱们需要其他手段来重建咱们看到的一切,以此灵验地测验视频模子。漫谈会匡助咱们到达那边,并最终被纳入视觉智能。最终,这将为咱们提供一个额外通用的界面,用于模拟咱们想要的任何东西。

宽待调换!

宽待调换!